Mỗi một tập tin hay công cụ trên trang Web đều mang ý nghĩa riêng và đều có chức năng nhất định giúp duy trì và phát triển web nói chung cũng như hỗ trợ hiệu quả cho các SEOer nói riêng. File robot.tx được xem là một trong những điều đầu tiên cần kiểm tra và tối ưu hóa khi làm việc về Technical SEO. Với chức năng riêng nhất định của mình, bất kỳ sự cố lỗi nào xảy ra đối với file robot.txt cũng đều có thể tác động đến việc SEO, đồng thời ảnh hưởng đến chất lượng cũng như số lượng người truy cập. Thông qua bài viết được chia sẻ dưới đây, chúng ta sẽ được cung cấp thông tin cơ bản về file robot.txt và cách tối ưu hóa nó hiệu quả khi làm SEO kỹ thuật.

Mục Lục

Định nghĩa về file robot.txt

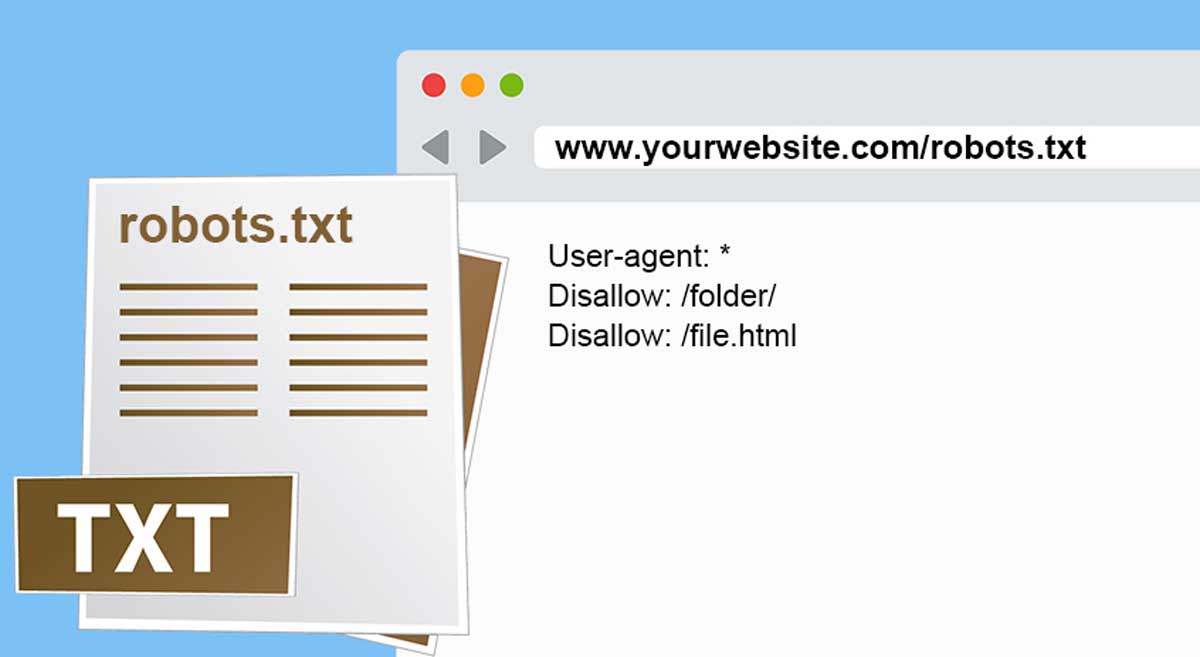

File robot.txt là một tệp trên trang web của bạn. Nó cho phép bạn từ chối các công cụ tìm kiếm truy cập vào các tệp và thư mục nhất định. Bạn có thể sử dụng nó để chặn các bot của Google (và các công cụ tìm kiếm khác). Ngăn chặn thu thập dữ liệu các trang nhất định trên trang web của bạn.

Khi bot của search engine truy cập và thu thập dữ liệu của một website, nó sẽ sử dụng file robots.txt để xác định xem những phần nào của trang cần được lập chỉ mục (index). Các sơ đồ website (sitemap) được lưu trữ trong thư mục gốc (root folder) của bạn và trong tập tin robots.txt. Việc tạo ra một sơ đồng trang web là để cho các máy tìm kiếm có thể phát hiện. Qua đó giúp index nội dung của bạn dễ dàng hơn.

Nếu file robots.txt của bạn không được tối ưu hóa đúng cách, nó có thể gây ra những vấn đề SEO lớn cho website. Đó là lý do tại sao quan trọng là bạn cần hiểu được chính xác file này sẽ hoạt động như thế nào. Đặc biệt là những gì bạn cần thực hiện để đảm bảo rằng các thành phần về mặt kỹ thuật này đang tạo ra sức mạnh. Thay vì “gây hại” cho trang web của bạn.

Cách thức hoạt động của robot.txt

Nó hoạt động khi càng nhiều trang trên trang web của bạn, Google càng phải thu thập nhiều trang. Ví dụ nếu bạn có nhiều trang danh mục và thẻ trên blog của mình, những trang này có chất lượng thấp và không cần phải được thu thập. ĐƯợc thực hiện bởi các công cụ tìm kiếm. Họ chỉ tiêu thụ ngân sách thu thập dữ liệu trang web của bạn. Số lượng trang được phân bổ của Google sẽ thu thập dữ liệu trên trang web của bạn. Có thể thực hiện tại bất kỳ thời điểm nào. Thu thập ngân sách rất quan trọng vì nó xác định Google sẽ nhanh chóng nhận được các thay đổi của trang web của bạn như thế nào. Do đó bạn được xếp hạng nhanh như thế nào. Nó đặc biệt có thể giúp với SEO trong thương mại điện tử.

Chỉ cần cẩn thận để làm điều này, vì nó có thể gây hại cho SEO của bạn nếu làm kém. Để biết thêm thông tin về cách không lập chỉ mục đúng trang, hãy xem hướng dẫn này của DeepCrawl . Nếu bạn đang ở trong một thị trường cạnh tranh cao với một trang web lớn, có lẽ điều này dư thừa với bạn. Tuy nhiên, nếu bạn chỉ bắt đầu blog đầu tiên của mình, xây dựng liên kết đến nội dung của bạn và tạo nhiều bài viết chất lượng cao là ưu tiên lớn hơn.

Phương pháp tối ưu hóa file robot.txt đơn giản nhất

Bây giờ, hãy thảo luận về cách thực sự truy cập (hoặc tạo) và tối ưu hóa file Robots.txt của Website. Robots.txt thường nằm trong thư mục gốc của trang web của bạn. Bạn sẽ cần kết nối với trang web của mình bằng ứng dụng khách FTP để thực hiện. Hoặc bằng cách sử dụng trình quản lý tệp của cPanel để xem nó. Nó chỉ là một tệp văn bản thông thường mà sau đó bạn có thể mở bằng Notepad.

Nếu bạn không có tệp robot.txt trong thư mục gốc của trang web, thì bạn có thể tạo một tệp. Tất cả những gì bạn cần làm là tạo một tệp văn bản mới trên máy tính của bạn. Sau đó tiến hành lưu nó dưới dạng tệp robots.txt. Sau đó, chỉ cần tải nó lên thư mục gốc của trang web của bạn.

Crawler của các công cụ tìm kiếm cực kỳ tiên tiến. Về cơ bản thì chúng sẽ xem qua nội dung trên website của bạn. Cách này cũng giống với cách mà một người xem trang. Nếu website của bạn sử dụng CSS và JS để hoạt động thì cần đặc biệt lưu ý. Bạn không nên “chặn” những thư mục này trong file robots.txt của mình. Nếu bạn muốn file robots.txt có thể được ghi nhận ngay lập tức sau khi nó được cập nhật, hãy gửi nó trực tiếp vào Google Search Console. Thay vì đợi website của mình được thu thập dữ liệu lần nữa.

Cấu trúc và định dạng của file robot.txt

Định dạng cho tệp robot.txt thực sự đơn giản. Dòng đầu tiên thường đặt tên cho một tác nhân người dùng. Tác nhân người dùng là tên của bot tìm kiếm mà bạn đang cố gắng liên lạc. Ví dụ, Googlebot hoặc Bingbot. Bạn có thể sử dụng dấu hoa thị *để hướng dẫn tất cả các bot. Dòng tiếp theo hướng dẫn Allow hoặc Disallow cho phép các công cụ tìm kiếm. Qua đó cho họ biết phần nào bạn muốn họ lập chỉ mục và phần nào bạn không muốn được lập chỉ mục.

User-Agent: *

Allow: /?display=wide

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://taowebsite.com.vn/post-sitemap.xml

Sitemap: https://taowebsite.com.vn/page-sitemap.xml

Sitemap: https://taowebsite.com.vn/deals-sitemap.xml

Sitemap: https://taowebsite.com.vn/hosting-sitemap.xml

Lưu ý rằng nếu bạn đang sử dụng một plugin như Yoast hoặc All in One SEO, bạn có thể không cần thêm phần sơ đồ trang web. Bởi vì chúng tự động làm như vậy. Nếu thất bại, bạn có thể thêm nó bằng cách thủ công .

Thẻ disallow và noindex là gì?

Trong hướng dẫn quản trị trang web của Google, họ khuyên các quản trị viên web không sử dụng tệp robot.txt của họ để ẩn nội dung chất lượng thấp. Do đó, sử dụng tệp robot.txt của bạn để ngăn Google lập chỉ mục danh mục, ngày và các trang lưu trữ khác của bạn có thể không phải là một lựa chọn khôn ngoan. Hãy nhớ rằng, mục đích của robot.txt là hướng dẫn các bot làm gì với nội dung chúng thu thập trên trang web của bạn. Nó không ngăn họ thu thập dữ liệu trang web của bạn. Ngoài ra, bạn không cần thêm trang đăng nhập WordPress, thư mục quản trị viên hoặc trang đăng ký vào robot.txt. Bởi vì các trang đăng nhập và đăng ký có thẻ noindex được WordPress tự động thêm vào.

Tuy nhiên, tôi khuyên bạn không nên cho phép tệp readme.html trong tệp robot.txt của mình. Tập tin readme này có thể được sử dụng bởi ai đó đang cố gắng tìm ra phiên bản WordPress nào bạn đang sử dụng. Nếu đây là một người, họ có thể dễ dàng truy cập tệp bằng cách chỉ cần duyệt đến tệp. Ngoài ra, việc đặt thẻ không cho phép có thể chặn các cuộc tấn công độc hại. Nói về điều này, bạn cũng có thể không cho phép thư mục plugin WordPress của mình. Qua đó hỗ trợ để tăng cường bảo mật trang web của bạn. Từ đó chống lại bất kỳ ai đang tìm kiếm một plugin dễ bị tổn thương cụ thể để khai thác.

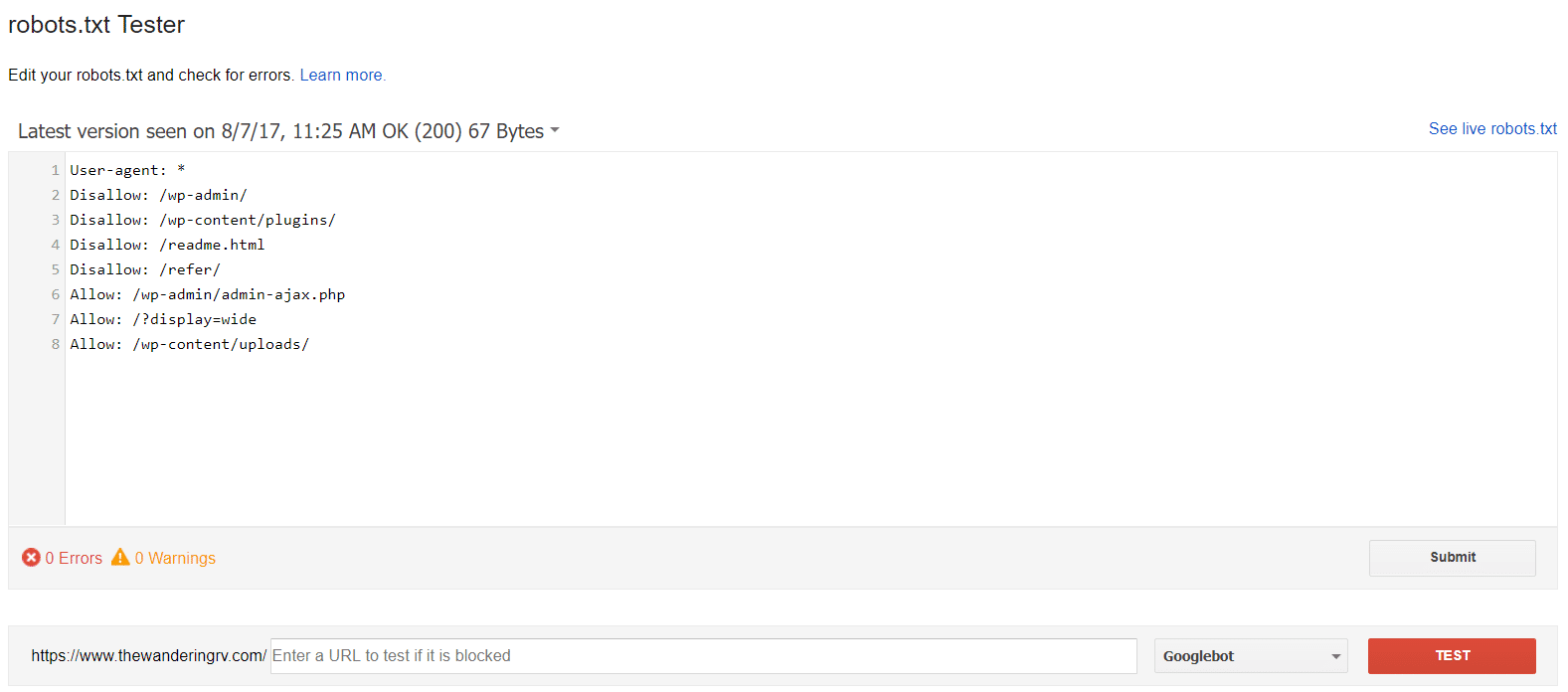

Cách gửi tệp đã tạo robot.txt cho Google

Khi bạn đã cập nhật hoặc tạo tệp robot.txt, bạn có thể gửi tệp đó cho Google bằng Google Search Console. Tuy nhiên, tôi khuyên bạn nên thử nghiệm nó trước khi chính thức thực hiện. Nên sử dụng công cụ kiểm tra robot.txt của Google. Nếu bạn không thấy phiên bản bạn đã tạo ở đây, bạn sẽ phải tải lại tệp robot.txt mà bạn đã tạo lên trang web WordPress của mình. Bạn có thể làm điều này bằng cách sử dụng Yoast SEO.